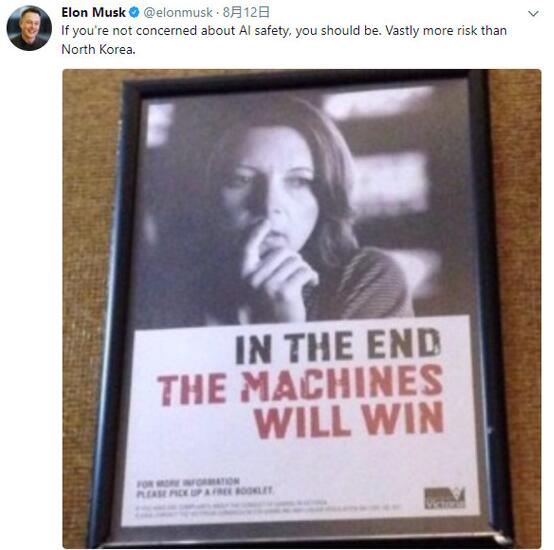

据Futurism报道,科技大亨伊隆·马斯克(Elon Musk)不久前在推特上发布了一张照片,引发人们对人工智能(AI)安全性的争论。当时马斯克发布了有关赌博上瘾广告的图片,上面写着“最终机器会赢”,显然他不仅仅指赌博机。更重要的是,马斯克称AI带来的危险比朝鲜核武器更大。

在随后的推文中,马斯克详细阐述了对AI系统开发进行监管的必要性。这与他本月早些时候所说的话相呼应,当时他说:“我认为,任何对公众构成危险的事情,至少政府应该有所了解,因为政府的义务之一就是确保公共福利。没有人喜欢受到监管,但对公众有危险的任何东西(包括汽车、飞机、食品以及药品等)都应该受到管制,AI也是如此。”

浏览对马斯克推文的评论发现,似乎大多数人都在某种程度上同意马斯克的意见。名为丹尼尔·佩德拉萨(Daniel Pedraza)的用户认为:“我们需要一个适应性较强的框架,不需要固定的规则、法律或原则,这对管理AI有好处。这个领域正在不断地变化和演进,任何固定的规则很快就会失效。”

许多专家都不愿意AI发展得太快。它造成的威胁听起来可能有点儿像科幻小说中的场景,但它们最终可能被证明是有效的。像史蒂芬·霍金(Stephen Hawking)这样的专家早就发出警告,宣称AI有终结人类的可能。在2014年采访中,这位著名的物理学家说:“AI的发展可能预示着人类的终结。” 他甚至认为自动化的扩散对中产阶级是一种有害的力量。

另一位专家、MetaMed Research的首席科学官迈克尔·瓦萨尔(Michael Vassar)指出:“如果远超人类的通用人工智能没有受到谨慎监管,可以肯定的是,人类将在非常短的时间内灭绝。”

很显然,至少在科学界,AI的自由发展可能不符合人类的最佳利益。很多人已经开始着手制定这些规则,以确保AI的发展“合乎道德规范”。电气与电子工程师协会提出了他们的第一份规则草案,希望能引导开发人员朝着正确的方向发展。

此外,在政府介入之前,科技巨头们也正在制定自我监管规则。来自谷歌、亚马逊、微软、IBM以及Facebook等大型科技公司的研究人员和科学家已经开始讨论,以确保AI造福于人类,而不是成为人类的生存威胁。

当然,要想达到足以威胁人类生存的程度,AI还有很长的路要走。然而,AI的进步是突飞猛进的。著名未来学家雷·库兹韦尔(Ray Kurzweil)预言,计算机将在2045年变得比人类更聪明。然而,他并不认为这是件可怕的事。也许,科技公司的自我监管将足以确保这些担忧变得毫无意义,或者最终可能需要政府的帮助。不管你的感觉如何,现在开始这些对话不算杞人忧天。但与此同时,也不要过于担心,除非你是个有竞争力的玩家。